Raspberry Piで顔検出した顔画像をAWS経由でLINE通知してみた!

本記事は、遠隔からRaspberryPiのカメラを起動し、顔検出した画像をLINEに通知します。

キーワードは「AWS IoT Device Shadow、IoT Rule」、「AWS Lambda」、「LINE Nortify」です。

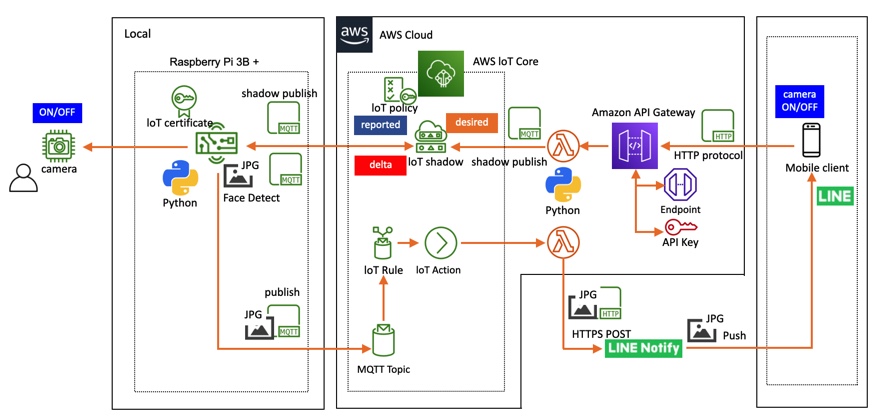

- 構成図

- LINE Notifyを登録とアクセストークン発行

- AWS Lambda関数の作成と登録

- AWS IoT Rule登録

- AWS IoT モノ・Shadow登録、AWS API Gateway登録、iPhoneアプリ作成

- 検証

Device Shadowは別記事の「AWS IoT Device Shadowを使ってみた!(Part1〜Part4)」を使用します。

尚、AWS IoT Device Shadowを使ってみた!(Part3) - Atom's tech blog のRasberry Piのソースコード部分は本記事をご参照ください。

顔検出とMQTTメッセージ送信(画像ファイル)する処理を追加しているため。

構成図

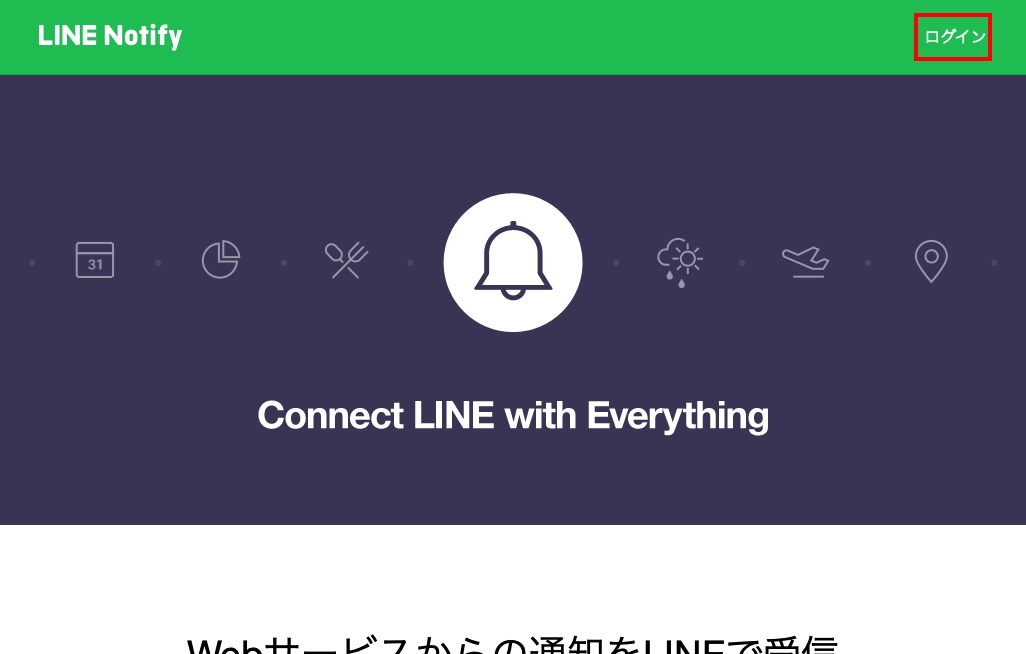

LINE Notifyを登録とアクセストークン発行

LINE Notifyへアクセスします。

ログインボタンをクリックします。

LINEに登録しているメールアドレスと、パスワードを入力します。

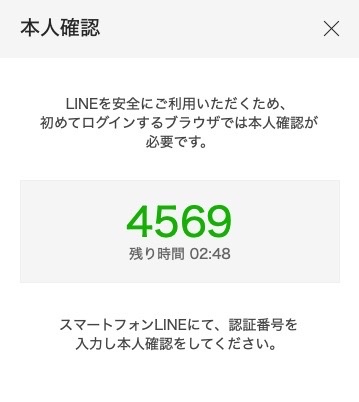

Webブラウザで表示された暗証番号をスマートフォンに入力し、「 本人確認」ボタンをタップします。

LINE NotifyのWeb画面でログインを確認します。

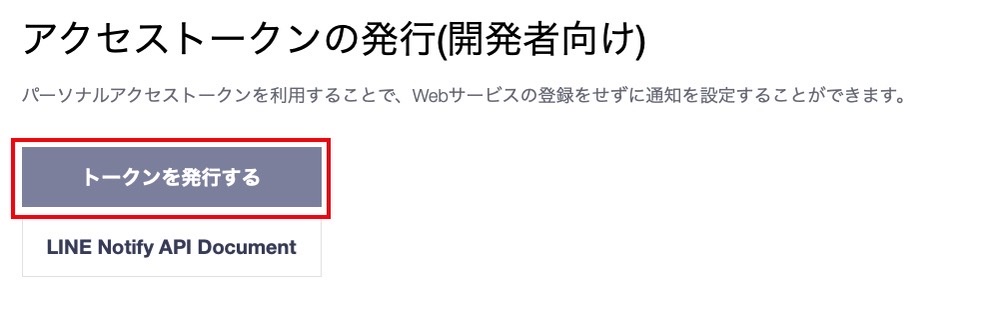

「 マイページ 」を開き、「 トークンを発行する」ボタンをクリックします。

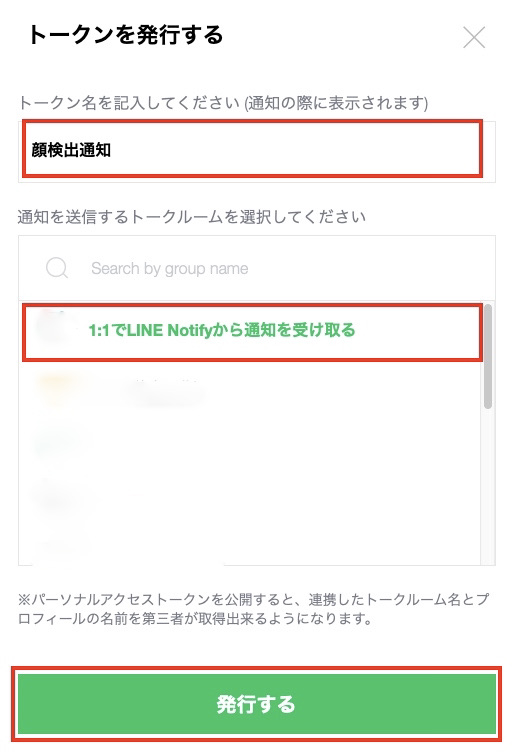

「 トークン名 」、「 トークンルーム(今回はお試しなので自分自身 [1:1で....]にします)」を選択し、「 発行する」ボタンをクリックします。

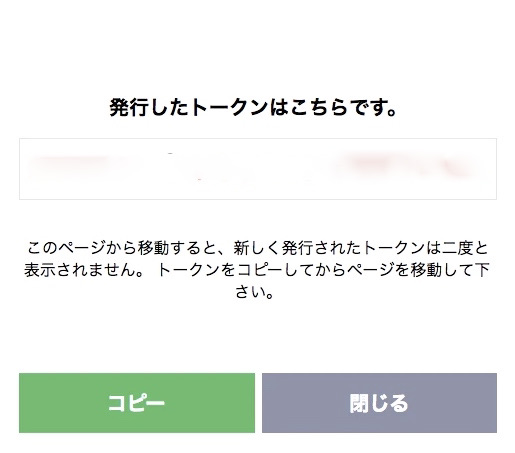

完了するとトークン番号がダイアログ表示されますので、この「 トークン番号 」をメモしておいてください。

AWS Lambda関数でPush通知する時に使用します。

AWS Lambda関数の作成と登録

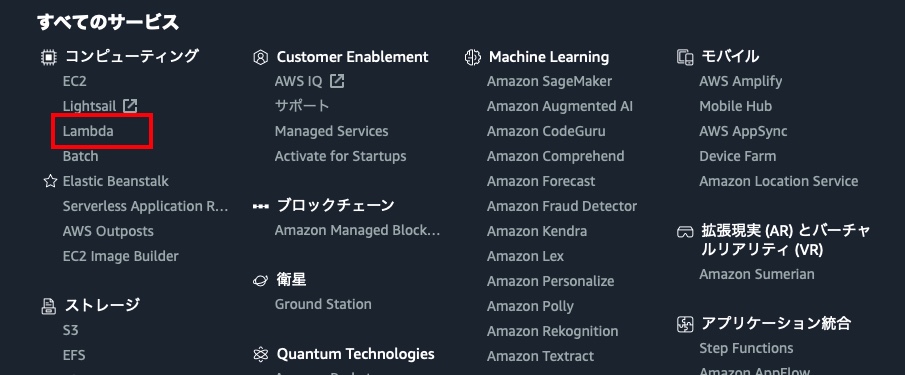

AWS Lambdaコンソールにアクセスします。

LINE Notifyへ通知するLambda関数を作成します。

「 関数の作成 」ボタンをクリックします。

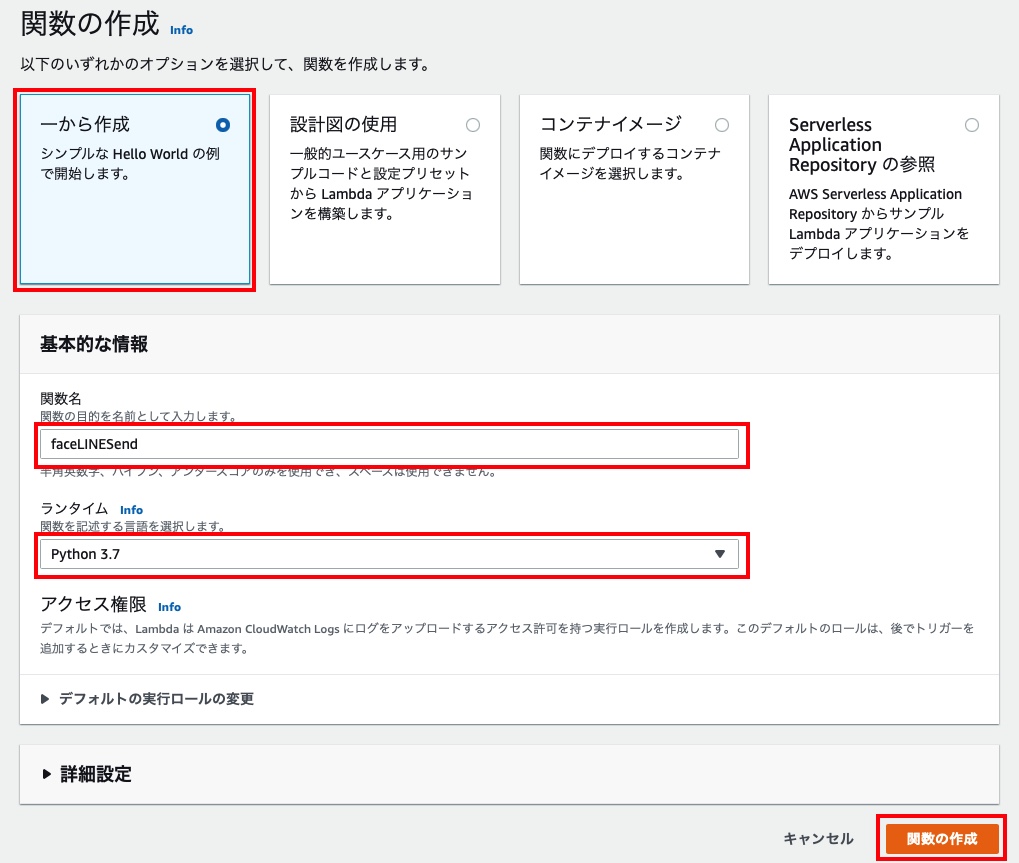

関数の作成画面で「 一から作成 」を選択、「関数名」を入力、「ランタイム」でPython3.7を選択し、「 関数の作成」ボタンをクリックします。

関数の作成が完了すると以下の画面に遷移します。

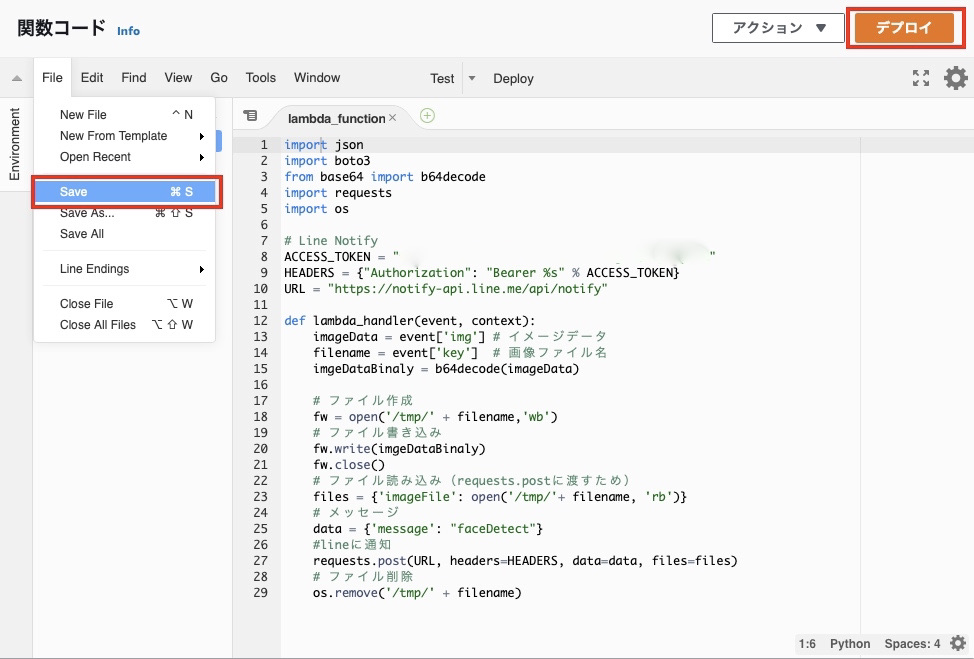

ブラウザを下スクロールすると「関数コード」がありますので、そちらに下記ソースコードをコピペします。

ソースコード説明

メモしたLINEのアクセストークンはここのLambda関数で設定します。

Raspberry Piから受信したMQTTメッセージのイメージデータとファイル名(13行目と14行目)を取得します。

Pasberry Piから送信されるイメージデータがエンコードしているので、15行目でデーコードします。

16行目で受信したファイル名でLambdaのtmpフォルダにバイナリ形式で保存します。 (保存しなくても実現できると思いますが、わからなかったので一旦保存します。) AWS S3を使う方法もありますが、ここはあえてS3を使わないやり方でトライしています。

保存したファイルをバイナリ形式で開き、27行目でメッセージと画像ファイルを添付しHTTPS送信します。

最後にLambdaのtmpに保存した画像ファイルを削除します。

ソースコード

import json import boto3 from base64 import b64decode import requests import os # Line Notify ACCESS_TOKEN = "LINE Notifyのアクセストークンを設定してください" HEADERS = {"Authorization": "Bearer %s" % ACCESS_TOKEN} URL = "https://notify-api.line.me/api/notify" def lambda_handler(event, context): imageData = event['img'] # イメージデータ filename = event['key'] # 画像ファイル名 imgeDataBinaly = b64decode(imageData) # ファイル作成 fw = open('/tmp/' + filename,'wb') # ファイル書き込み fw.write(imgeDataBinaly) fw.close() # ファイル読み込み(requests.postに渡すため) files = {'imageFile': open('/tmp/'+ filename, 'rb')} # メッセージ data = {'message': "faceDetect"} #lineに通知 requests.post(URL, headers=HEADERS, data=data, files=files) # ファイル削除 os.remove('/tmp/' + filename)

「 コピペ 」と「 LINEアクセストークン」を入力した後、「 ファイルを保存 」し、「 デプロイ 」ボタンをクリックします。

Layersの登録

ソースコードで「 imoort requests 」していますが、Lambdaはデフォルトでインストールされていないため、Layersを使ってrequestsライブラリを使用できるようにします。

本来はAWS EC2でrequestsライブラリを作成するべきなのですが、EC2は立ち上げていない(使用していない)ので、MACで作成します。

$ mkdir -p layer/python $ cd layler/python $ pip3 install requests -t . $ cd .. $ zip -r ../layer.zip * $ cd .. $ ls -l layer.zip -rw-r--r-- 1 999125 1 8 15:45 layer.zip

AWS Lambdaコンソールから作成した「layer.zip」ファイルをアップロードします。

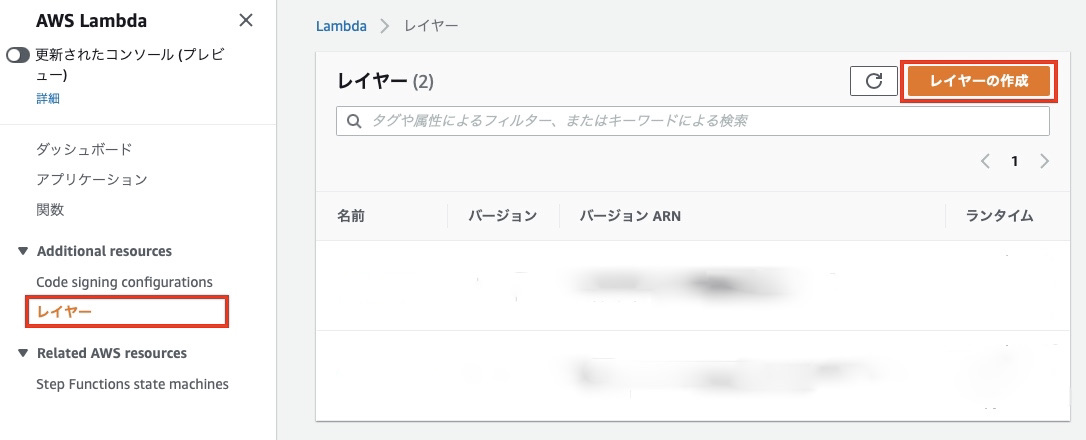

Lambdaコンソールの左メニューから「 レイヤー 」を選択し、「 レイヤーの作成 」ボタンをクリックします。

「名前」、「 .zipファイルをアップロード 」を選択し、アップロードボタンをクリックし作成した「 layer.zip」ファイルを選択しアップロードします。

「ランタイム 」は「 Python3.6、3.7、3.8 」を選択し、「 作成 」ボタンをクリックします。

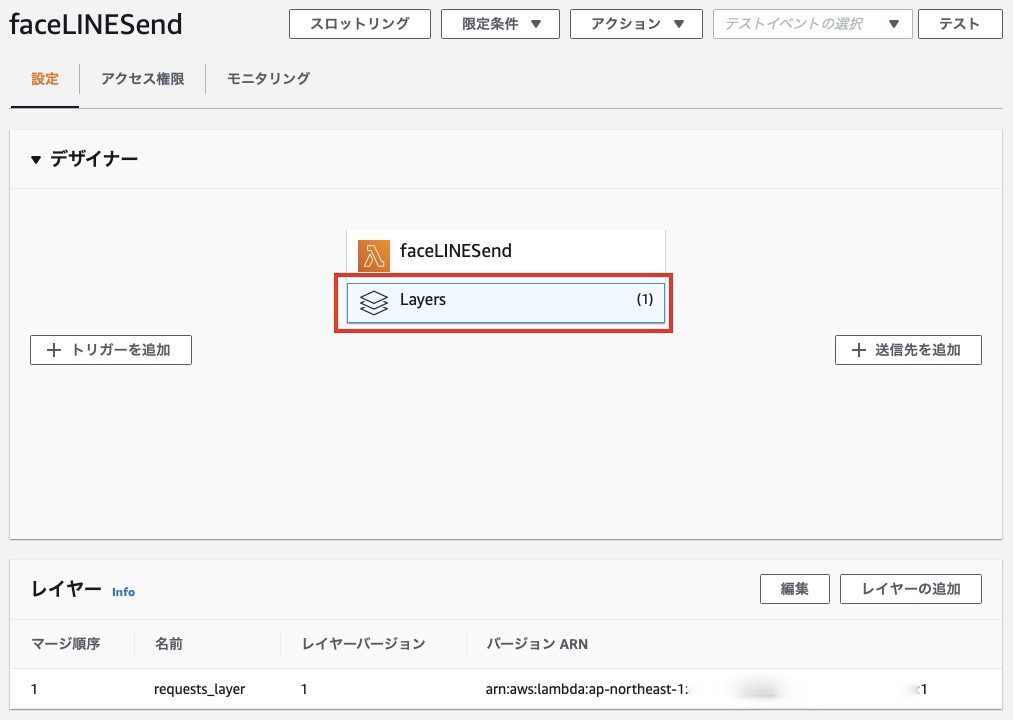

「 Layers 」を選択し、「 レイヤーの追加 」ボタンをクリックします。

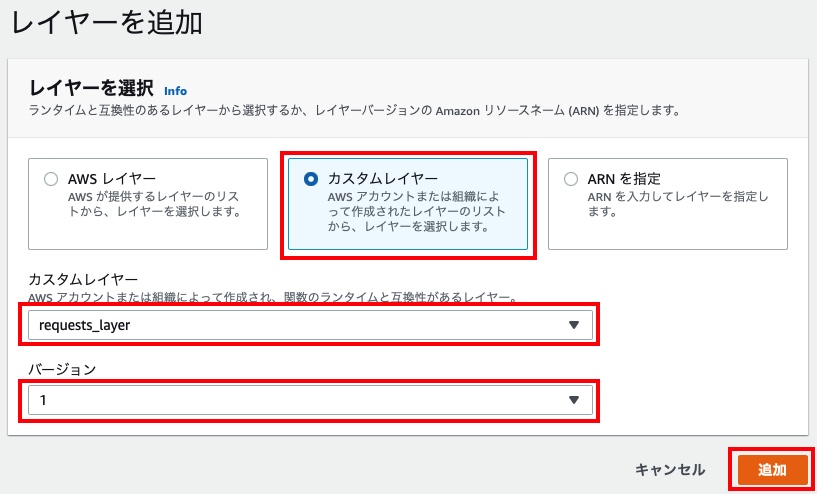

レイヤーを選択します。「カスタムレイヤー 」を選択、カスタムレイヤーのプルダウンをクリックし、登録した「 requests_layer」、バージョンを「 1 」を選択し、最後に「 追加 」ボタンをクリックし追加します。

「 Layers 」をクリックすると、レイヤーに「 requests_layer」が追加できていることを確認できます。

AWS IoT Rule登録

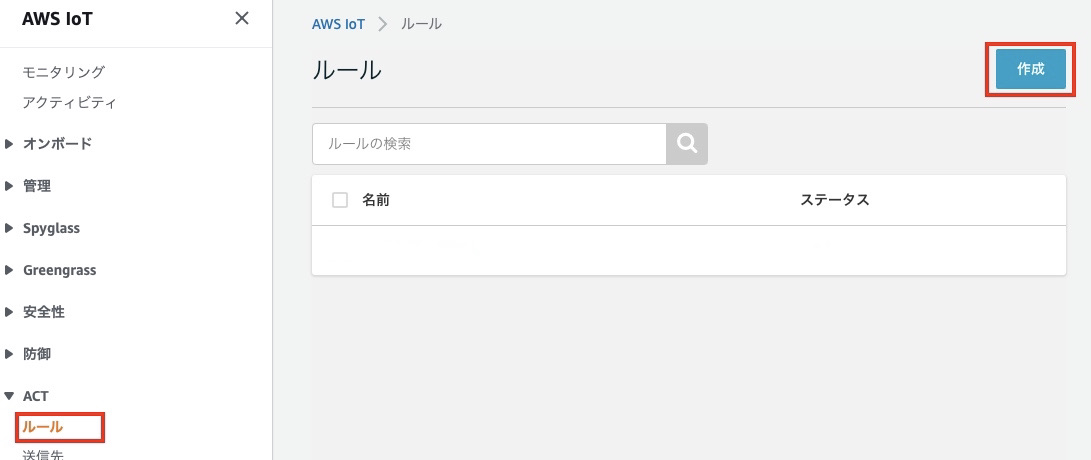

AWS Iot Coreコンソールにアクセスします。

AWS IoTコンソール画面左メニューから「 ACT -> ルール 」を選択し、「 作成 」ボタンをクリックします。

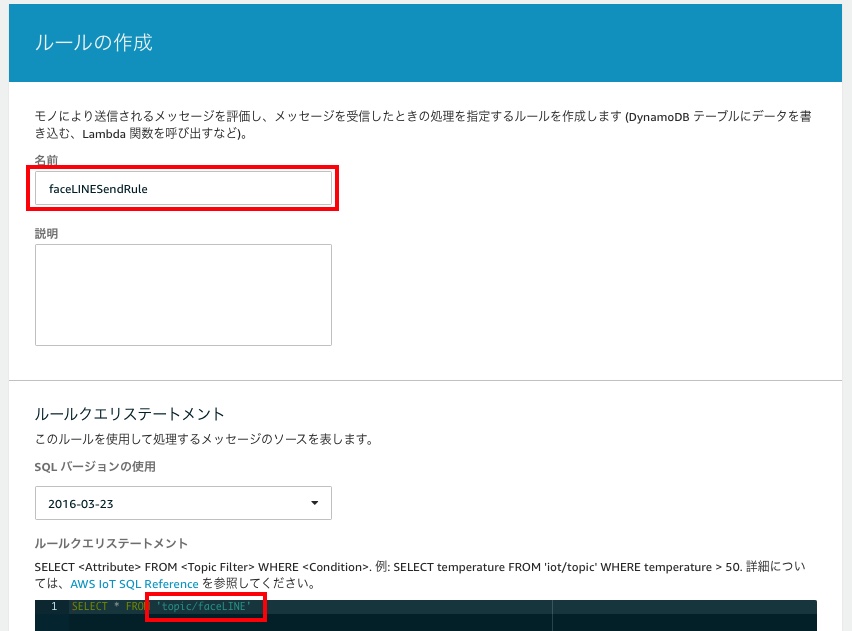

「 名前 」を入力、ルールクエリステートメントでルール対象となるtopicを変更( topic/faceLINE )します。

イメージはRaspberry Piから送信されたtopicの名称が「 topic/faceLINE」のMQTTメッセージのみにルールを適用することを意味します。

次に「 topic/faceLINE」を受信したときのアクションを設定します。

「 アクションの追加 」ボタンをクリックします。

LINEへ通知するLambda関数を起動したいので、「 メッセージデータを渡すLambda関数を読み出す 」を選択し、「 アクションの設定 」ボタンをクリックします。

作成、登録済みのLambda関数を選択し、「 アクションの追加 」ボタンをクリックします。

最後に「 ルールの作成 」ボタンをクリックし、ルール作成します。

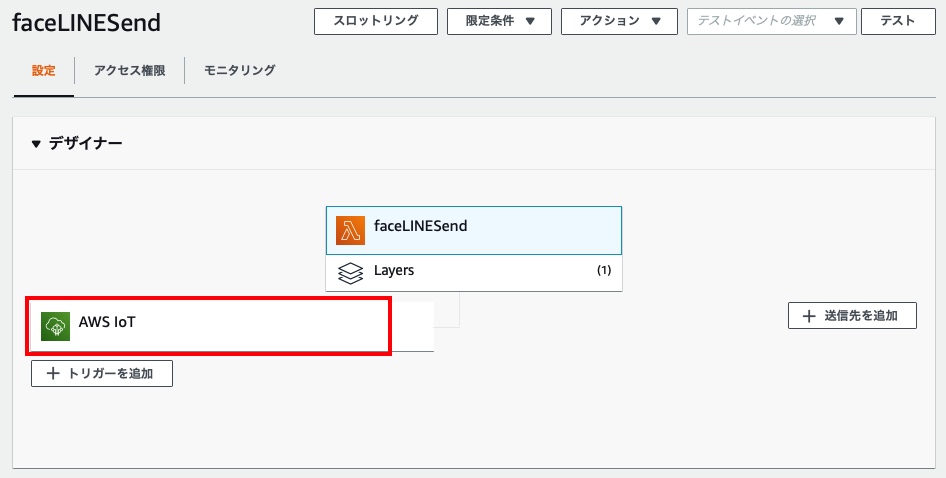

ルールの登録が完了すると、LambdaコンソールからLambda関数に「AWS IoT」がトリガーとして追加されていることが確認できます。

AWS IoT モノ・Shadow登録、AWS API Gateway登録、iPhoneアプリ作成

下記記事のリンクをご参照ください。

AWS IoT Device Shadowを使ってみた!(Part1) - Atom's tech blog

AWS IoT Device Shadowを使ってみた!(Part2) - Atom's tech blog

AWS IoT Device Shadowを使ってみた!(Part3) - Atom's tech blog

AWS IoT Device Shadowを使ってみた!(Part4) - Atom's tech blog

Part3のRaspberryPiのソースコードは、下記の(shadowFaceDetect.py)を使用してください。

ソースコード(shadowFaceDetect.py)

ソースコード内の下記変数は、各自のAWS環境に合わせてコード記入してください。

- host(endpoint)/ rootCAPath / certificatePath / privateKeyPath

from AWSIoTPythonSDK.MQTTLib import AWSIoTMQTTShadowClient from AWSIoTPythonSDK.MQTTLib import AWSIoTMQTTClient import logging import time import json import cv2 import datetime import base64 # HaarCascade cascade_fn = "./haarcascade_frontalface_default.xml" cascade = cv2.CascadeClassifier(cascade_fn) # VideoCapture用インスタンス生成 cap = cv2.VideoCapture(0) # バッファサイズ1に変更 cap.set(cv2.CAP_PROP_BUFFERSIZE, 1) # カメラフレームサイズをVGAに変更する cap.set(cv2.CAP_PROP_FRAME_WIDTH, 640) # カメラ画像の横幅を640に設定 cap.set(cv2.CAP_PROP_FRAME_HEIGHT, 480) # カメラ画像の縦幅を480に設定 # カメラ状態保存処理 def cameraStatusSet(onoff): global cameraState # カメラ起動指示有無確認 if onoff == "1" : cameraState = 'on' else: cameraState = 'off' # IoT Device Shadow "reported" UpDate処理 def updateState(newState): JSONPayload = '{"state":{"reported":{"camera":' + str(newState) +'}}}' print("updating...\n") print(JSONPayload) deviceShadowHandler.shadowUpdate(JSONPayload, None, 5) cameraStatusSet(newState) # Custom Shadow callback def customShadowCallback_Delta(payload, responseStatus, token): print(responseStatus) payloadDict = json.loads(payload) print("++++++++DELTA++++++++++") print("camera: " + str(payloadDict["state"]["camera"])) print("version: " + str(payloadDict["version"])) print("+++++++++++++++++++++++\n\n") # reported Update newState = json.dumps(payloadDict["state"]["camera"]) updateState(newState) host = "自分の環境に合わせてください" port = 8883 clientId = "RaspberryPi" thingName = "RaspberryPi_Camera" rootCAPath = "自分の環境に合わせてください" certificatePath = "自分の環境に合わせてください" privateKeyPath = "自分の環境に合わせてください" # Configure logging logger = logging.getLogger("AWSIoTPythonSDK.core") logger.setLevel(logging.DEBUG) streamHandler = logging.StreamHandler() formatter = logging.Formatter('%(asctime)s - %(name)s - %(levelname)s - %(message)s') streamHandler.setFormatter(formatter) logger.addHandler(streamHandler) ################## ### MQTT shadow ### ################## # Init AWSIoTMQTTShadowClient myAWSIoTMQTTShadowClient = AWSIoTMQTTShadowClient(clientId) myAWSIoTMQTTShadowClient.configureEndpoint(host, port) myAWSIoTMQTTShadowClient.configureCredentials(rootCAPath, privateKeyPath, certificatePath) # AWSIoTMQTTShadowClient configuration myAWSIoTMQTTShadowClient.configureAutoReconnectBackoffTime(1, 32, 20) myAWSIoTMQTTShadowClient.configureConnectDisconnectTimeout(10) # 10 sec myAWSIoTMQTTShadowClient.configureMQTTOperationTimeout(5) # 5 sec # Connect to AWS IoT myAWSIoTMQTTShadowClient.connect() # Create a deviceShadow with persistent subscription deviceShadowHandler = myAWSIoTMQTTShadowClient.createShadowHandlerWithName(thingName, True) # Listen on deltas deviceShadowHandler.shadowRegisterDeltaCallback(customShadowCallback_Delta) ################### ### MQTT Message ### ################### topic = "topic/faceLINE" bucket = "binary-upload-20210106" clientIdPubSub = "RaspberryPiPubSub" # Init AWSIoTMQTTClient myAWSIoTMQTTClient = None myAWSIoTMQTTClient = AWSIoTMQTTClient(clientIdPubSub) myAWSIoTMQTTClient.configureEndpoint(host, 8883) myAWSIoTMQTTClient.configureCredentials(rootCAPath, privateKeyPath, certificatePath) # AWSIoTMQTTClient connection configuration myAWSIoTMQTTClient.configureAutoReconnectBackoffTime(1, 32, 20) myAWSIoTMQTTClient.configureOfflinePublishQueueing(-1) # Infinite offline Publish queueing myAWSIoTMQTTClient.configureDrainingFrequency(2) # Draining: 2 Hz myAWSIoTMQTTClient.configureConnectDisconnectTimeout(10) # 10 sec myAWSIoTMQTTClient.configureMQTTOperationTimeout(5) # 5 sec # Connect and subscribe to AWS IoT myAWSIoTMQTTClient.connect() time.sleep(2) # カメラON/OFF状態を初期化 cameraState = 'off' # Loop forever while True: # カメラOPEN状態 while(cap.isOpened()): # カメラ起動状態指示 ? if cameraState == 'on': # カメラで顔データを取得する ret, img = cap.read() # 画像のグレースケールと平滑化 gray_image = cv2.cvtColor(img, cv2.COLOR_BGR2GRAY) gray_image = cv2.equalizeHist(gray_image) # OpenCV顔検出 dets = cascade.detectMultiScale(gray_image, scaleFactor=1.3, minNeighbors=3, minSize=(30, 30), flags=cv2.CASCADE_SCALE_IMAGE) for(x,y,w,h) in dets: # 顔部分を抽出 face_image = img[y:y+h, x:x+w] # 日時取得 dt_now = datetime.datetime.now() dateStr = dt_now.strftime('%Y%m%d_%H%M%S_%f') # 画像ファイル名作成 filename = 'image_'+ dateStr + '.jpg' filenamePath = './image/'+filename # 画像ファイル保存 cv2.imwrite(filenamePath,face_image) # 送信する画像ファイルを読出し sendImg = open(filenamePath, 'rb').read() # binary -> base64変換 base64Img = base64.b64encode(sendImg).decode("utf-8") # メッセージデータ作成 payloadMsg=json.dumps({"img": base64Img,"bucket": bucket,"key": filename}) #send Command print("FaceDetect Send") myAWSIoTMQTTClient.publish(topic, payloadMsg, 1) time.sleep(1) time.sleep(10)

検証

Raspberry Pi Pythonスクリプト起動

最初にRaspberry Pi Pythonスクリプトを起動しておきます。

$ python3 shadowFaceDetect.py

iPhoneアプリからONボタンタップ前のShadow状態

Shadow状態はRaspberry Piのカメラ状態(reported)、iPhoneから指定する状態(desired)共に0(カメラOFF)状態が確認できます。

iPhoneアプリからONボタンタップ時の状態とLog表示

iphoneよりONボタンをタップすると、desired=1(カメラON指示)、reported(カメラON指示検出)が確認できます。

RaspberryPi Log表示(抜粋)

++++++++DELTA++++++++++ camera: 1 version: 482 +++++++++++++++++++++++ updating...

AWS IoT Core Shadow状態

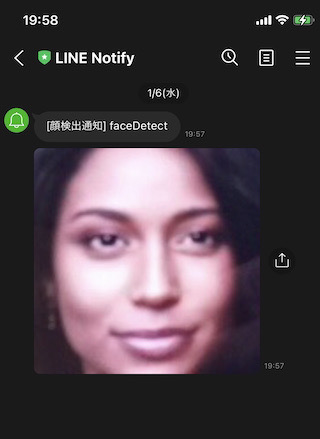

LINE通知確認

記事ではRaspberry PiカメラにiPhone画面上に画像ファイルを表示して顔検出させています。

iPhone画面表示イメージ

LINE通知受信

RaspberryPiでカメラピクセル数を640/480でキャプチャーしているため、解像度は落ちていますが顔検出した画像データ、「faceDetect」メッセージもLINE通知できています。

RaspberryPi Log表示(抜粋)

「FaceDetect Send」の文字列表示できており、RaspberryPiでも正常に顔検出&MQTTメッセージ送信しています。

2021-01-08 19:51:01,602 - AWSIoTPythonSDK.core.protocol.mqtt_core - INFO - Performing sync publish... 2021-01-08 19:51:01,603 - AWSIoTPythonSDK.core.protocol.internal.workers - DEBUG - Produced [puback] event 2021-01-08 19:51:01,604 - AWSIoTPythonSDK.core.protocol.internal.workers - DEBUG - Dispatching [puback] event 2021-01-08 19:51:01,654 - AWSIoTPythonSDK.core.protocol.internal.workers - DEBUG - Produced [message] event 2021-01-08 19:51:01,655 - AWSIoTPythonSDK.core.protocol.internal.workers - DEBUG - Dispatching [message] event 2021-01-08 19:51:01,656 - AWSIoTPythonSDK.core.shadow.deviceShadow - DEBUG - shadow message clientToken: 2021-01-08 19:51:01,656 - AWSIoTPythonSDK.core.shadow.deviceShadow - DEBUG - Token is in the pool. Type: accepted 2021-01-08 19:51:01,657 - AWSIoTPythonSDK.core.protocol.internal.clients - DEBUG - Invoking custom event callback... 2021-01-08 19:51:02,670 - AWSIoTPythonSDK.core.protocol.connection.cores - DEBUG - stableConnection: Resetting the backoff time to: 1 sec. FaceDetect Send

うまくいきました。

最初Raspberry Pi 3 model b+にMTCNNをインストールして使用しましたが、動作がもっさりしてしまうので、検出率は落ちますが検出が早い「HaarCascade」を使用しました。